Una ricerca all’avanguardia suggerisce che è possibile ricostruire immagini ad alta risoluzione dall’attività cerebrale umana, aprendo la strada a una tecnologia rivoluzionaria che un giorno potrebbe leggere la mente.

Wim Wenders aveva già immaginato qualcosa del genere nel 1991 nel film “Fino alla fine del mondo”. In questo film lo scienziato Farber crea un avveniristico dispositivo per registrare i sogni direttamente da chi sta dormendo. Questo ha portato alla nascita di una nuova forma di dipendenza: Claire, il ricercatore e suo figlio sono ossessionati dalla necessità di vedere i loro sogni registrati sulla macchina digitale. Questa macchina sarebbe poi stata in grado di fornire immagini attraverso la stimolazione biochimica del cervello, permettendo alla vista di una persona cieca di vedere.

In un altro film di fantascienza, Minority Report del 2002, Steven Spielberg immaginava un futuro in cui un “dipartimento di polizia pre-crimine” preveniva i crimini prima che accadessero, grazie alle visioni di tre chiaroveggenti geneticamente modificati. Se questo concetto poteva sembrare al di là del possibile, i recenti progressi delle neuroscienze ci stanno avvicinando alla generazione di immagini direttamente dal cervello umano.

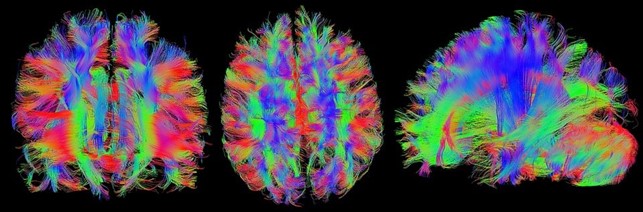

Due ricercatori giapponesi, Yu Takagi e Shinji Nishimoto, hanno recentemente pubblicato un lavoro innovativo che esplora l’uso dei modelli di diffusione (classe di modelli di apprendimento automatico in grado di generare nuovi dati sulla base dei dati di addestramento.), in particolare “Stable Diffusion” un innovativo algoritmo, per creare immagini ad alta risoluzione dall’attività cerebrale umana. Utilizzando la risonanza magnetica funzionale (fMRI), lo studio mirava a scoprire la relazione tra i modelli di visione computerizzata e il sistema visivo umano, ricostruendo le esperienze visive dall’attività cerebrale.

La fMRI misura i cambiamenti del flusso sanguigno nel cervello per rilevare l’attività neuronale. I ricercatori sono riusciti a ricostruire immagini ad alta risoluzione senza bisogno di un addestramento estensivo o di una messa a punto dei modelli di apprendimento profondo. Si tratta di un risultato significativo, poiché i precedenti tentativi di ricostruire immagini visive dalla fMRI si basavano sull’addestramento di modelli generativi profondi su grandi insiemi di dati, un compito impegnativo nelle neuroscienze a causa delle dimensioni ridotte dei campioni.

I modelli di diffusione latente (LDM) offrono una soluzione a questa limitazione. I modelli LDM possono imparare a creare immagini trasformando semplici modelli di rumore in immagini complesse, utilizzando un set di immagini per imparare a creare nuove immagini simili. Una volta addestrato, il modello può creare immagini partendo da un modello di rumore casuale e trasformandolo gradualmente in un’immagine che sembra appartenere al set di dati.

Nel loro studio, Takagi e Nishimoto hanno mappato componenti specifiche della diffusione stabile a regioni cerebrali distinte, fornendo un’interpretazione quantitativa dei LDM dal punto di vista delle neuroscienze. Questa mappatura delle regioni cerebrali potrebbe avere implicazioni significative per la ricerca futura su come il cervello umano elabora le informazioni visive.

Anche se la tecnologia di lettura della mente può sembrare ancora fantascienza, questa ricerca ci porta un passo più vicino a un futuro in cui sarà possibile – chissà forse un giorno non proprio lontano – una comunicazione diretta tra il cervello e le macchine.

Per chi volesse approfondire: https://sites.google.com/view/stablediffusion-with-brain/.

C’è da sottolineare che lo studio non è più solo un preprint, ma è stato accettato da CVPR (Conference on Computer Vision and Pattern Recognition) conferenza annuale sulla visione artificiale e il riconoscimento dei modelli, considerata la più importante nel suo campo. https://cvpr2023.thecvf.com/.

Mirko Compagno

Quest’opera è distribuita con Licenza Creative Commons Attribuzione – Non commerciale 4.0 Internazionale.